计算机科学与工程学院人工智能学院硕士研究生发表高水平论文

近日,计算机科学与工程学院人工智能学院2019级硕士研究生吴伟在周华兵教授的指导下,在多媒体领域顶刊IEEE TransactionsonMultimedia(TMM,中科院SCI一区)发表科研论文:“Semantic-supervised Infrared and Visible Image Fusion via a Dual-discriminator Generative Adversarial Network”。该论文第一单位为武汉工程大学智能机器人湖北省重点实验室和计算机科学与工程学院人工智能学院。

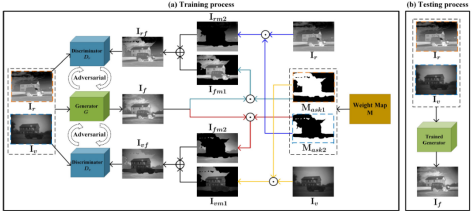

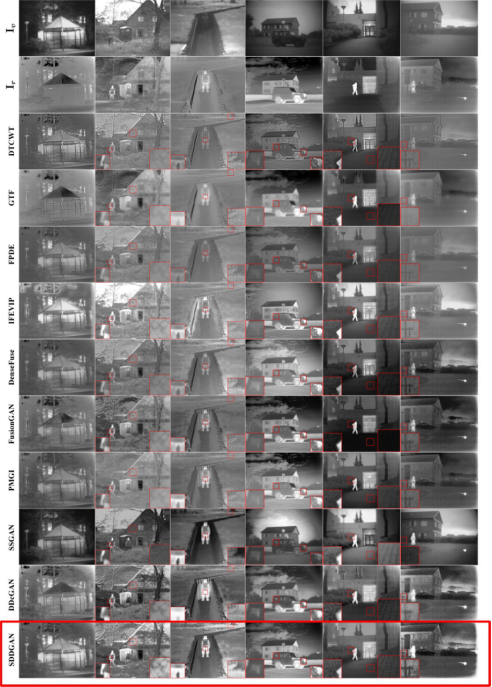

图像融合是一种图像增强技术,旨在将不同类型传感器采集的图像相结合,生成一张信息量更丰富的图像,从而促进后续高层的处理和决策,是计算机视觉领域的研究热点。如何提高融合图像的高层语义表达能力,仍然是一个具有挑战性的难题。受到经典基于生成对抗网络技术的启发,该论文提出了基于语义监督及双鉴别器生成对抗网络的红外与可见光图像融合算法。论文通过标注语义的监督,使得生成器学会了不同语义目标的融合机理,可以在保留源图像模态特征的同时提高融合图像的语义一致性。此外,区别于传统的生成对抗网络,论文中的双鉴别器分别用于识别红外与可见光图像的分布,然后作用于融合图像中特定模态(红外/可见光)的语义目标,以保持和增强它们的模态特征。实验结果表明,该方法优于前沿最优算法。图1展示了该论文的算法框架。图2展示了论文算法和前沿算法定性的对比实验结果。

图1算法总体框架

图2论文算法与前沿最优算法的视觉对比图

武汉工程大学智能机器人湖北省重点实验室在多源信息融合领域开展了深入研究,相关研究成果在安全、工业、民用和医疗等领域具有十分重要的科学意义。

【免责申明】本专题图片均来源于学校官网或互联网,若有侵权请联系400-0815-589删除。